Google тайно запустила приложение для мощного ИИ на смартфонах без интернета

Компания Google выпустила экспериментальное приложение для Android, позволяющее запускать сложные модели искусственного интеллекта прямо на смартфонах, без подключения к интернету. Этот шаг знаменует важный этап в стратегии компании по развитию периферийных вычислений (edge computing) и внедрению ИИ с акцентом на приватность пользователей.

Приложение AI Edge Gallery дает возможность загружать и выполнять модели ИИ с популярной платформы Hugging Face исключительно на устройстве. Это открывает доступ к таким задачам, как анализ изображений, генерация текста, помощь в программировании и ведение диалогов, при этом вся обработка данных происходит локально.

Выпущенное под открытой лицензией Apache 2.0 и доступное через GitHub (а не официальные магазины приложений), это решение стало последним шагом Google в стремлении сделать передовые возможности ИИ доступнее. Одновременно компания реагирует на растущие опасения пользователей относительно конфиденциальности данных при использовании облачных ИИ-сервисов.

«Google AI Edge Gallery — это экспериментальное приложение, которое дает в ваши руки мощь передовых генеративных ИИ-моделей, работающих исключительно на ваших Android-устройствах», — поясняется в руководстве пользователя. — «Погрузитесь в мир творческих и практических сценариев использования ИИ — всё работает локально, без необходимости подключения к интернету после загрузки модели».

[Изображение: Скриншоты интерфейса AI Edge Gallery: главный экран, выбор моделей Hugging Face, настройки ускорения обработки (Источник: Google)]

Как облегченные модели Google обеспечивают производительность уровня облака на мобильных устройствах

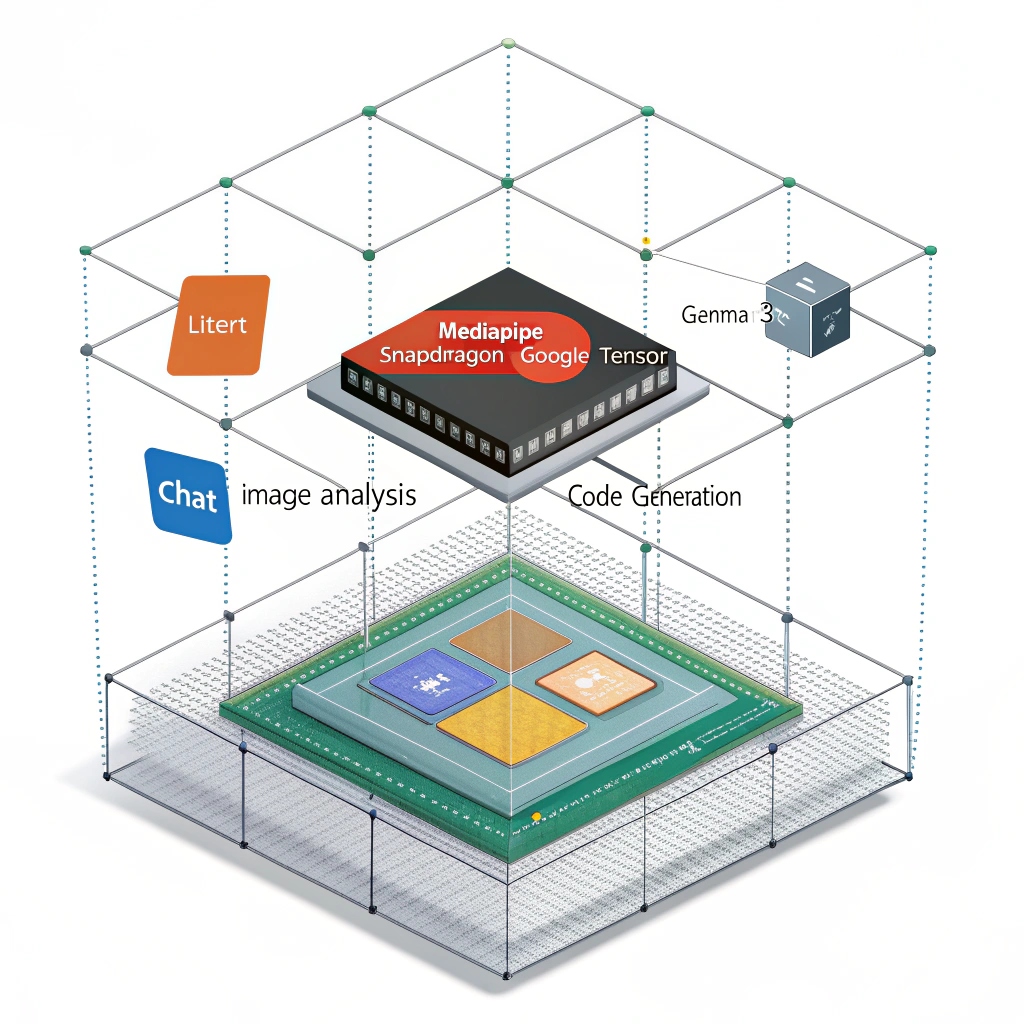

Приложение построено на платформах Google LiteRT (ранее известной как TensorFlow Lite) и MediaPipe, специально оптимизированных для запуска ИИ-моделей на мобильных устройствах с ограниченными ресурсами. Система поддерживает модели из различных фреймворков машинного обучения, включая JAX, Keras, PyTorch и TensorFlow.

Основу решения составляет модель Gemma 3 от Google — компактная языковая модель размером 529 мегабайт. Она способна обрабатывать до 2585 токенов в секунду на этапе предварительного заполнения контекста (prefill inference) при использовании мобильных графических процессоров (GPU). Такая производительность обеспечивает ответы менее чем за секунду для задач вроде генерации текста или анализа изображений, что делает пользовательский опыт сопоставимым с облачными альтернативами.

Приложение предлагает три ключевые функции:

AI Chat: для ведения многоходовых диалогов.

Ask Image: для ответов на вопросы по загруженным изображениям (визуальный вопросно-ответ).

Prompt Lab: для одношаговых задач, таких как суммаризация текста, генерация кода, переписывание контента.

Пользователи могут переключаться между разными моделями, сравнивая их производительность и возможности. Приложение в реальном времени отображает метрики, такие как время до первого токена (time-to-first-token) и скорость декодирования (decode speed).

«Квантование в формат Int4 сокращает размер модели до 4 раз по сравнению с bf16, уменьшая использование памяти и задержки», — отмечает Google в технической документации, ссылаясь на методы оптимизации, делающие работу крупных моделей на мобильном железе возможной.

[Изображение: Функция AI Chat: детализированные ответы и метрики производительности, включая скорость токенов и задержку (Источник: Google)]

Почему локальная обработка ИИ может изменить правила игры в приватности данных и корпоративной безопасности

Подход с локальной обработкой решает растущие проблемы приватности данных в ИИ-приложениях, особенно в отраслях, работающих с конфиденциальной информацией. Храня данные на устройстве, организации могут соблюдать требования регуляторов по защите приватности, одновременно используя возможности ИИ.

Этот сдвиг представляет собой фундаментальный пересмотр подхода к приватности в ИИ. Вместо того чтобы рассматривать приватность как ограничение для возможностей ИИ, локальная обработка превращает её в конкурентное преимущество. Организациям больше не нужно выбирать между мощным ИИ и защитой данных — теперь они могут получить и то, и другое. Отсутствие зависимости от сети также означает, что проблемы с подключением к интернету, традиционно являвшиеся серьезным ограничением для ИИ-приложений, перестают влиять на основную функциональность.

0 комментариев